- INTRO

- Lectures XVIIe-XVIIIe

- Lectures XIXe-XXe

- 1820-1840

- 1840-1860

- 1860-1880

- 1880-1900

- 1900-1910

- 1910-1920

- 1920-1930

- 1920s

- Breton

- Tanguy - Ernst

- Eluard

- Jacob - Cocteau

- Gramsci

- Lukacs

- Hesse

- Woolf

- Valéry

- Alain

- Mansfield

- Lawrence

- Bachelard

- Zweig

- Larbaud - Morand

- Döblin

- Musil

- Mann

- Colette

- Mauriac

- MartinDuGard

- Spengler

- Joyce

- Pabst

- S.Lewis

- Dreiser

- Pound

- Heisenberg

- TS Eliot

- Supervielle - Reverdy

- Sandburg

- Duhamel - Romains

- Giraudoux - Jouhandeau

- Svevo - Pirandello

- Harlem - Langston Hughes

- Cassirer

- Lovecraft

- Zamiatine

- W.Benjamin

- Chesterton

- Akutagawa

- Tanizaki

- 1930-1940

- 1940-1950

- 1940s

- Chandler

- Sartre

- Beauvoir

- Mounier

- Borges

- McCullers

- Camus

- Horkheimer - Adorno

- Cela

- Wright

- Bellows - Hopper - duBois

- Gödel - Türing

- Bogart

- Trevor

- Brecht

- Bataille - Michaux

- Merleau-Ponty - Ponge

- Simenon

- Aragon

- Algren - Irish

- Mead - Benedict - Linton

- Vogt - Asimov

- Orwell

- Montherlant

- Buzzati - Pavese

- Lewin - Mayo - Maslow

- Fallada

- Malaparte

- Bloch

- Canetti

- Lowry - Bowles

- Koestler

- Boulgakov

- Welty

- 1950-1960

- 1950s

- Moravia

- Rossellini

- Nabokov

- Cioran

- Arendt

- Aron

- Marcuse

- Packard

- Wright Mills

- Vian - Queneau

- Quine - Austin

- Blanchot

- Sarraute - Butor - Duras

- Ionesco - Beckett

- Rogers

- Dürrenmatt

- Sutherland - Bacon

- Peake

- Durrell - Murdoch

- Graham Greene

- Kawabata

- Kerouac

- Bellow - Malamud

- Martin-Santos

- Fanon - Memmi

- Riesman

- Böll - Grass

- Baldwin - Ellison

- Bergman

- Tennessee Williams

- Bradbury - A.C.Clarke

- Erikson

- Bachmann - Celan - Sachs

- Rulfo-Paz

- Carpentier

- Achébé - Soyinka

- Pollock

- Mishima

- Salinger - Styron

- Fromm

- Pasternak

- O'Connor

- 1960-1970

- 1960s

- Ricoeur

- Roth - Elkin

- Lévi-Strauss

- Burgess

- Heller - Toole

- Naipaul

- U.Johnson - C.Wolf

- J.Rechy - H.Selby

- Antonioni

- T.Wolfe - N.Mailer

- Capote - Vonnegut

- Plath

- Burroughs

- Veneziano

- Godard

- Onetti - Sábato

- Sillitoe

- McCarthy - Minsky

- Sagan

- Gadamer

- Martin Luther King

- Laing

- P.K.Dick - Le Guin

- Lefebvre

- Althusser

- Lacan

- Foucault

- Jankélévitch

- Goffman

- Barthes

- Cortázar

- Warhol

- Dolls

- Berne

- Grossman

- McLuhan

- Soljénitsyne

- Lessing

- Leary

- Kuhn

- Ellis

- HarperLee

- 1970-1980

- 1980-1990

- 1990-2000

- Lectures XXIe

- Promenades

- Paysages

- Contact

Algorithms - Safiya Umoja Noble, "Algorithms of Oppression: How Search Engines Reinforce Racism" (2018) - Reza Zafarani, Mohammad Ali Abbasi, et Huan Liu, "Social Media Mining : An Introduction" (2014) - Cathy O'Neil, "Weapons of Math Destruction" (2016) - Minna Ruckenstein, "The Feel of Algorithms" (2023) - Douglas G. McIlwraith, Haralambos Marmanis, Dmitry Babenko, "Algorithms of the Intelligent Web" (2016) - Virginia Eubanks, "Automating Inequality :How High-Tech Tools Profile, Police, and Punish the Poor" (2018) - ...

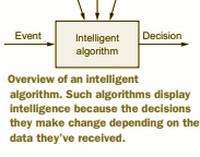

Nous vivons à l’ère de l’algorithme - "We live in the age of the algorithm. Increasingly, the decisions that affect our lives–where we go to school, whether we can get a job or a loan, how much we pay for health insurance–are being made not by humans, but by machines. In theory, this should lead to greater fairness? - ".. We have more data and technology than ever in our daily lives and more social, political, and economic inequality and injustice to go with it..." - Le World Wide Web est l'infrastructure sous-jacente d'une société de l'information basée sur l'internet et c'est l'outil principal que des milliards de personnes utilisent pour interagir sur l'internet. Tout progrès industriel se fait désormais en développant des services d'information sur l'internet. "With the maturity of cloud computing and wireless communications, the web is becoming not only a platform for publishing and accessing information, but also a platform where information services can be developed, deployed, and delivered to billions of users anytime and anywhere". Les données massives (big data) fournissent un contenu riche pour la création de services polyvalents et constituent également le moyen d'enrichir les services avec de l'intelligence et d'améliorer ainsi l'expérience de l'utilisateur des services sur le web.

Grâce à ces services intelligents, le web change notre vie et cette "intelligence" est obtenue par l'analyse des données générées par les interactions entre les utilisateurs et le contenu du web. La création d'une "intelligence web", à structure essentiellement algorithmique et graphique, est donc au cœur du développement actuel des technologies numériques. C'est ici le discours dans sa grandiose formulation optimiste, qu'une pensée critique ne peut accepter en l'état. Bien des livres, bien des auteurs nous incitent à réfléchir à la manière dont ces systèmes automatisés ont été, seront conçus, diffusés et utilisés : si l'on accepte de s'interroger sur la "neutralité" effective de ces systèmes et l'évidence des services et du surcroît d'intelligence supposée qu'ils nous procurent, peut-être verrons-nous surgir en nous des interrogations sur un monde que nous acceptons en l'état, avec ses inégalités, ses injustices, ses discriminations, ses misères pour tout dire, et sans nous poser la moindre question ...

"Algorithms of the Intelligent Web", Second Edition, Douglas G. McIlwraith, Haralambos Marmanis, Dmitry Babenko (2016)

".. the intelligent web is about designing and implementing more naturally responsive applications that make our online experiences better in some quantifiable way" - De fait, le livre explore des sujets tels que l'apprentissage automatique, le filtrage collaboratif, le traitement du langage naturel et d'autres techniques clés qui permettent de créer des systèmes intelligents. Une approche pratique avec des exemples concrets, et un ouvrage qui couvre les fondements des algorithmes utilisés dans de nombreux systèmes. Le domaine de l'intelligence artificielle et des algorithmes évoluant rapidement, bien d'autres ouvrages verront encore le jour en ce domaine ...

Séquences d'étapes logiques et structurées qui permettent d'atteindre un objectif spécifique à partir de données d'entrée, il n'est d'informatique sans conception d'algorithmes. Ils sont ainsi au cœur de la résolution de bien des problèmes : qu'il s'agisse de trier une liste, de chercher une information, de chiffrer des données, ou de prendre des décisions complexes, les algorithmes fournissent les étapes nécessaires pour arriver à une solution. Un bon algorithme est aussi conçu pour résoudre un problème de manière le plus rapide possible et avec un minimum de ressources : de la qualité des algorithmes dépend donc le plus souvent l'efficacité d'un programme informatique. Sans algorithmes il n'est de tâches complexes qui ne puissent être automatisées. Enfin, les algorithmes sont essentiels dans le développement de l'intelligence artificielle, c'est par leurs structures que les machines apprennent, que des décisions peuvent être prises, qu'il est possible de s'adapter à de nouvelles situations, et ce sans être explicitement programmées pour chaque tâche ...

La conception d'un algorithme efficace constitue donc un défi majeur, entre résolution du problème, rapidité d'exécution et utilisation des ressources. Mais pour autant sa neutralité effective n'est pas acquise tant au niveau des données qui l'alimentent que de sa conception. Il peut génénérer des résultats inattendus mais aussi prendre parfois l'aspect de "boîtes noires", une opacité qui ne permet pas de maîtriser de bout en bout sa logique, et pose ainsi des problèmes de confiance et de responsabilité. Enfin, tout algorithme peut être sujet à une certaine vulnérabilité qui l'expose à des dysfonctionnements aux conséquences particulièrement importantes, notamment dans le domaine de la cryptographie ou pour de la gestion de données sensibles. On le voit, indispensable à notre monde totalement informatisé et numérisé, les algorithmes se doivent d'être conçus non seulement pour être efficaces et performants, mais aussi pour être équitables, transparents, et sécurisés. Une réflexion éthique et rigoureuse est nécessaire pour minimiser les risques associés à leur déploiement à grande échelle..

Et s'il est bien un domaine dans lequel les algorithmes jouent un rôle crucial, c'est dans le fonctionnement des réseaux sociaux. C'est par leur intermédiaire, que tout contenu émanant du Web est rendu visible et que s'organise l'expérience en ligne des utilisateurs...

Ici, donc, les algorithmes ont en charge d'analyser le comportement des utilisateurs, tels que leurs interactions, leurs centres d'intérêt, et leurs relations, pour personnaliser le contenu qui apparaît dans leurs flux. Les liens tissés avec la plateforme de référence résultent de cette pseudo prise en compte des préférences de l'utilisateur par celle-ci. Ensuite, Ces mêmes plateformes de réseaux sociaux vont utiliser des algorithmes pour prioriser le contenu susceptible de générer de l'engagement (likes, partages, commentaires), ce qui a pour effet d'augmenter le temps que les utilisateurs passent sur la plateforme, ce qui est bénéfique pour les revenus publicitaires. Et dans ce contexte, les algorithmes permettent aux entreprises de cibler des publics spécifiques en se basant sur des données utilisateurs acquises dans une stratégie de consentement plus ou moins clairement édictée : c'est ici que l'on mesure toute l'efficacité des réseaux sociaux, efficacité commerciale bien évidemment. On connaît par ailleurs l'effet dit de "bulle de filtre" (Eli Pariser), un effet qualifié de "secondaire" des algorithmes au cours duquel les utilisateurs ne voient que du contenu qui renforce leurs opinions existantes, ce qui, selon la formule consacrée, peut limiter leur exposition à des points de vue divers. Intention plus singulière encore, du moins quant à la mise en oeuvre, la fameuse "gestion de la Désinformation" : des algorithmes, encore et toujours, sont utilisés pour détecter et limiter la propagation de fausses informations, identifier des tendances de comportement suspect ou des informations qui sont signalées par les utilisateurs comme inappropriées. Un sujet polémique et ambigu que personne ne maîtrise véritablement ...

"The Platform Society : Public Values in a Connective World", written by Jose van Dijck, Thomas Poell, Martijn de Waal (2018)

Avant toute considération sur la mise en place globale d'un monde qui ne serait désormais géré que par des systèmes essentiellement algorithmiques, des systèmes quasiment invisibles dont tout utilisateur du Web emprunte les chemins sans même le savoir, il est une réalité particulièrement visible qui désormais soutient de part en part notre monde, celui des "plateformes numériques" (the rise of digital platforms), nouveau moteur du progrès économique et de l'innovation technologique. Ces plateformes offrent des services personnalisés, contribuent à l’innovation et à la croissance économique, tout en permettant à chacun de contourner efficacement les organisations existantes, les réglementations lourdes et les dépenses inutiles. Discours dominant et fortement argumenté, dans le prolongement de l'exaltation de la richesse des réseaux sociaux en ligne : des vertus de la connectivité intégrale (Aigrain, P., "Sharing: Culture and the Economy in the Internet Age", Amsterdam University Press, 2012 ; Jenkins, H., S. Ford, J. Green. "Spreadable Media: Creating Value and Meaning in a Networked Culture. New York", New York University Press, 2013 ; Leadbeater, C., "We-Think: Mass Innovation Not Mass Production", London: Profile Books, 2009). La croissance exponentielle des plateformes en ligne a pour corollaire économique la diffusion d'une « culture participative » qui a commencé avec l’émergence des réseaux de médias sociaux et du Web 2.0 dans les premières années du millénaire.

S'ils reconnaissent que les plateformes en ligne sont au cœur d’un développement important, les auteurs de "The Platform Society" privilégient la "vision compréhensive d’un monde connectif où les plateformes ont pénétré le cœur des sociétés - affectant les institutions, les transactions économiques et les pratiques sociales et culturelles - obligeant ainsi les gouvernements et les États à ajuster leurs structures juridiques et démocratiques". Loin du discours emphatique qui célèbre une supposée "révolution", les plateformes sont ici décrites comme infiltrant progressivement les institutions et les pratiques par lesquelles les sociétés démocratiques sont organisées. D'où le terme qui est privilégie de «société de plateformes», qui met l’accent sur la relation inextricable entre les plateformes en ligne et les structures sociales. "Les plateformes ne reflètent pas le social : elles produisent les structures sociales dans lesquelles nous vivons" (N. Couldry, A. Hepp, "The Mediated Construction of Reality", London, 2016). Mais dans une société où la plupart des interactions sont effectuées par l’intermédiaire d’Internet, ces plateformes, censées améliorer les avantages personnalisés et les gains économiques, vont exercer simultanément une pression sur les moyens collectifs et les services publics. Le sous-titre du livre indique la perspective plus large que les auteurs disent assumer : quel rôle jouent les plateformes en ligne dans l’organisation des valeurs publiques dans les sociétés nord-américaines et européennes ( what role do online platforms play in the organization of public values in North American and western European societies) ? Les plateformes ne sont ni neutres, ni sans valeur ; elles viennent avec des normes et des valeurs spécifiques inscrites dans leurs architectures, et le plus souvent les sociétés européennes sont enracinées dans des valeurs idéologiques différentes de celles introduites par de nombreuses plateformes...

Safiya Umoja Noble, dans "Algorithms of Oppression: How Search Engines Reinforce Racism" (2018), nous décrit comment les algorithmes peuvent perpétuer des biais raciaux et sexistes en ligne, en particulier dans le contexte des moteurs de recherche et des réseaux sociaux.

Noble nous démontre ainsi que les algorithmes ne sont pas "neutres", qu'ils sont conçus par des êtres humains qui, consciemment ou non, intègrent leurs propres points de vue, plus ou moins maîtrisés, dans les systèmes, et qui, dans les résultats de recherche obtenus, peuvent renforcer bien des stéréotypes existants jusqu'à produire différentes formes de discrimination (racisme, sexisme) qui se renforcent mutuellement ...

"The Power of Algorithms

This book is about the power of algorithms in the age of neoliberalism and the ways those digital decisions reinforce oppressive social relationships and enact new modes of racial profiling, which I have termed technological redlining. By making visible the ways that capital, race, and gender are factors in creating unequal conditions, I am bringing light to various forms of technological redlining that are on the rise. The near-ubiquitous use of algorithmically driven software, both visible and invisible to everyday people, demands a closer inspection of what values are prioritized in such automated decision-making systems.

Ce livre traite du pouvoir des algorithmes à l'ère du néolibéralisme et de la manière dont ces décisions numériques renforcent les relations sociales oppressives et mettent en œuvre de nouveaux modes de profilage racial, ce que j'ai appelé le redlining technologique. En rendant visibles les façons dont le capital, la race et le genre sont des facteurs de création de conditions inégales, je mets en lumière diverses formes de redlining technologique qui sont en train de se développer. L'utilisation quasi omniprésente de logiciels pilotés par des algorithmes, à la fois visibles et invisibles pour les gens de tous les jours, exige un examen plus approfondi des valeurs qui sont privilégiées dans ces systèmes de prise de décision automatisés.

Typically, the practice of redlining has been most often used in real estate and banking circles, creating and deepening inequalities by race, such that, for example, people of color are more likely to pay higher interest rates or premiums just because they are Black or Latino, especially if they live in low-income neighborhoods. On the Internet and in our everyday uses of technology, discrimination is also embedded in computer code and, increasingly, in artificial intelligence technologies that we are reliant on, by choice or not. I believe that artificial intelligence will become a major human rights issue in the twenty-first century. We are only beginning to understand the long-term consequences of these decision-making tools in both masking and deepening social inequality.

En règle générale, la pratique du redlining a été utilisée le plus souvent dans les milieux immobiliers et bancaires, créant et aggravant les inégalités en fonction de la race, de sorte que, par exemple, les personnes de couleur sont plus susceptibles de payer des taux d'intérêt ou des primes plus élevés simplement parce qu'elles sont noires ou latinos, en particulier si elles vivent dans des quartiers à faibles revenus. Sur l'internet et dans nos usages quotidiens de la technologie, la discrimination est également inscrite dans le code informatique et, de plus en plus, dans les technologies d'intelligence artificielle dont nous dépendons, par choix ou non. Je pense que l'intelligence artificielle deviendra un enjeu majeur pour les droits de l'homme au XXIe siècle. Nous commençons à peine à comprendre les conséquences à long terme de ces outils de prise de décision, qui masquent et aggravent les inégalités sociales.

This book is just the start of trying to make these consequences visible. There will be many more, by myself and others, who will try to make sense of the consequences of automated decision making through algorithms in society. Part of the challenge of understanding algorithmic oppression is to understand that mathematical formulations to drive automated decisions are made by human beings. While we often think of terms such as “big data” and “algorithms” as being benign, neutral, or objective, they are anything but. The people who make these decisions hold all types of values, many of which openly promote racism, sexism, and false notions of meritocracy, which is well documented in studies of Silicon Valley and other tech corridors...."

Ce livre n'est que le début d'une tentative de rendre ces conséquences visibles. Il y en aura beaucoup d'autres, de moi-même et d'autres, qui tenteront de donner un sens aux conséquences de la prise de décision automatisée par le biais d'algorithmes dans la société. Une partie du défi que représente la compréhension de l'oppression algorithmique est de comprendre que les formulations mathématiques qui conduisent les décisions automatisées sont faites par des êtres humains. Alors que nous pensons souvent que des termes tels que « big data » et « algorithmes » sont bénins, neutres ou objectifs, il n'en est rien. Les personnes qui prennent ces décisions ont toutes sortes de valeurs, dont beaucoup promeuvent ouvertement le racisme, le sexisme et de fausses notions de méritocratie, ce qui est bien documenté dans les études de la Silicon Valley et d'autres couloirs technologiques.... »

Noble illustre cette réalité de production algorithmique de résultats discriminatoires avec des exemples concrets : ainsi comment des recherches sur les jeunes filles noires aboutissent souvent à des contenus hypersexualisés ou négatifs. Plus encore, est contestable le modèle économique même des grandes entreprises technologiques qui, en monétisant les données des utilisateurs, encouragent des algorithmes qui favorisent des contenus sensationnalistes et stéréotypés. Autant de pratiques qui contribuent à la perpétuation des inégalités et de la désinformation.

Safiya Umoja Noble défend ainsi une régulation plus stricte des algorithmes et une éducation plus approfondie du public sur les dangers de la dépendance aux moteurs de recherche et autres technologies numériques pour obtenir de l'information.

".. We have more data and technology than ever in our daily lives and more social, political, and economic inequality and injustice to go with it. In this book, I have sought to critique the political-economic framework and representative discourse that surrounds racial and gendered identities on the web, but more importantly, I have shined a light on the way that algorithms are value-laden propositions worthy of our interrogation. I am particularly mindful of the push for digital technology adoption by Black / African Americans, divorced from the context of how digital technologies are implicated in global racial power relations. I have tried to show how traditional media misrepresentations have been instantiated in digital platforms such as search engines and that search itself has been interwoven into the fabric of American culture. Although rhetoric of the information age broadly seeks to disembody users, or at least to minimize the hegemonic backdrop of the technological revolution, African Americans have embraced, modified, and contextualized technology into significantly different frameworks despite the relations of power expressed in the socioalgorithms. This book can open up a dialogue about radical interventions on socio-technical systems in a more thoughtful way that does not further marginalize people who are already in the margins. Algorithms are, and will continue to be, contextually relevant and loaded with power..."

« Nous avons plus de données et de technologies que jamais dans notre vie quotidienne et plus d'inégalités et d'injustices sociales, politiques et économiques qui vont avec. Dans ce livre, j'ai cherché à critiquer le cadre politico-économique et le discours représentatif qui entourent les identités raciales et sexuées sur le web, mais plus important encore, j'ai mis en lumière la façon dont les algorithmes sont des propositions chargées de valeurs qui méritent d'être interrogées. Je suis particulièrement attentive à la pression exercée par les Noirs et les Afro-Américains en faveur de l'adoption de la technologie numérique, sans tenir compte de la manière dont les technologies numériques sont impliquées dans les relations de pouvoir raciales globales. J'ai essayé de montrer comment les fausses représentations des médias traditionnels ont été instanciées dans les plateformes numériques telles que les moteurs de recherche et que la recherche elle-même a été imbriquée dans le tissu de la culture américaine. Bien que la rhétorique de l'ère de l'information cherche largement à désincarner les utilisateurs, ou du moins à minimiser la toile de fond hégémonique de la révolution technologique, les Afro-Américains ont adopté, modifié et contextualisé la technologie dans des cadres significativement différents malgré les relations de pouvoir exprimées dans les socio-algorithmes. Ce livre peut ouvrir un dialogue sur les interventions radicales sur les systèmes socio-techniques d'une manière plus réfléchie qui ne marginalise pas davantage les personnes qui sont déjà en marge. Les algorithmes sont, et continueront d'être, contextuellement pertinents et chargés de pouvoir... »

"Weapons of Math Destruction" (2016), Cathy O'Neil aborde les dangers des algorithmes dans diverses sphères, y compris les réseaux sociaux, en soulignant comment ils peuvent souvent perpétuer l'injustice et exacerber les inégalités sociales et économiques.

O'Neil introduit le concept de "Weapons of Math Destruction" (WMD) pour décrire des algorithmes qui sont opaques, non régulés, massivement déployés et qui causent des dommages aux individus et à la société. Le livre détaille comment les WMD affectent divers aspects de la vie quotidienne, notamment l'éducation (par exemple, les classements d'écoles), l'emploi (avec les outils de filtrage de CV), les assurances, la justice pénale (les algorithmes de récidive), et la finance. Dans chaque cas, O'Neil montre comment ces algorithmes, loin d'être neutres, perpétuent et amplifient les inégalités...

"... In leaving academia for finance, I carried mathematics from abstract theory into practice. The operations we performed on numbers translated into trillions of dollars sloshing from one account to another. At first I was excited and amazed by working in this new laboratory, the global economy. But in the autumn of 2008, after I’d been there for a bit more than a year, it came crashing down. The crash made it all too clear that mathematics, once my refuge, was not only deeply entangled in the world’s problems but also fueling many of them. The housing crisis, the collapse of major financial institutions, the rise of unemployment—all had been aided and abetted by mathematicians wielding magic formulas. What’s more, thanks to the extraordinary powers that I loved so much, math was able to combine with technology to multiply the chaos and misfortune, adding efficiency and scale to systems that I now recognized as flawed..."

".. En quittant le monde universitaire pour la finance, j'ai fait passer les mathématiques de la théorie abstraite à la pratique. Les opérations que nous faisions sur les nombres se traduisaient par des billions de dollars qui passaient d'un compte à l'autre. Au début, j'étais enthousiaste et émerveillé à l'idée de travailler dans ce nouveau laboratoire, l'économie mondiale. Mais à l'automne 2008, après un peu plus d'un an de travail, tout s'est effondré. Le krach a mis en évidence le fait que les mathématiques, qui avaient été mon refuge, étaient non seulement profondément mêlées aux problèmes du monde, mais qu'elles en alimentaient également un grand nombre. La crise du logement, l'effondrement des grandes institutions financières, la montée du chômage, tout cela avait été aidé et soutenu par des mathématiciens maniant des formules magiques. De plus, grâce aux pouvoirs extraordinaires que j'aimais tant, les mathématiques ont pu se combiner à la technologie pour multiplier le chaos et le malheur, en ajoutant de l'efficacité et de l'ampleur à des systèmes que je reconnaissais désormais comme défectueux..."

" ... The math-powered applications powering the data economy were based on choices made by fallible human beings. Some of these choices were no doubt made with the best intentions. Nevertheless, many of these models encoded human prejudice, misunderstanding, and bias into the software systems that increasingly managed our lives. Like gods, these mathematical models were opaque, their workings invisible to all but the highest priests in their domain: mathematicians and computer scientists. Their verdicts, even when wrong or harmful, were beyond dispute or appeal. And they tended to punish the poor and the oppressed in our society, while making the rich richer. I came up with a name for these harmful kinds of models: Weapons of Math Destruction, or WMDs for short. I’ll walk you through an example, pointing out its destructive characteristics along the way...."

"... Les applications mathématiques qui alimentent l'économie des données reposent sur des choix faits par des êtres humains faillibles. Certains de ces choix ont sans doute été faits avec les meilleures intentions. Néanmoins, bon nombre de ces modèles encodaient des préjugés, des incompréhensions et des partis pris humains dans les systèmes logiciels qui géraient de plus en plus nos vies. Tels des dieux, ces modèles mathématiques étaient opaques, leur fonctionnement invisible pour tous, à l'exception des plus grands prêtres de leur domaine : les mathématiciens et les informaticiens. Leurs verdicts, même lorsqu'ils sont erronés ou nuisibles, sont incontestables et sans appel. Et ils avaient tendance à punir les pauvres et les opprimés de notre société, tout en enrichissant les riches. J'ai trouvé un nom pour ces modèles nuisibles : Les armes de destruction mathématique (ADM). Je vais vous présenter un exemple, en soulignant ses caractéristiques destructrices en cours de route...."

Et c'est bien l'opacité des algorithmes qui fait l'objet de bien des critiques : ces algorithmes sont généralement des "boîtes noires" et les personnes affectées par leurs décisions n'ont aucune visibilité sur la manière dont ces décisions sont prises, ni aucune possibilité de les contester. Un processus qui peut génèrer des impacts disproportionnés sur les populations les plus vulnérables. O'Neil critique donc le modèle économique derrière ces algorithmes, qui est souvent basé sur l'efficacité et la rentabilité à court terme, au détriment de l'équité et de la justice sociale, et appelle à une régulation plus stricte, à une plus grande transparence, et à l'élaboration d'algorithmes qui tiennent compte de l'éthique et de l'impact social.

Il est à noter toutefois que Cathy O’Brien a écrit deux ouvrages, "Trance Formation of America" (1995) puis "Access Denied: For Reasons of National Security" (2004), qui ont suscité de nombreux débats et controverses. Si, pour certains, ses livres ont contribué à nourrir des discussions sur la transparence gouvernementale et les abus de pouvoir, - l'auteur expose des supposés programmes de contrôle mental menés par le gouvernement des États-Unis, dans le cadre d'opérations clandestines et décrit son propre parcours comme étant marqué par des abus sévères dans le cadre de mystérieuses manipulations couvertes par le secret défense -, ils ont été souvent classés dans le domaine des "théories du complot", avançant en effet des affirmations non vérifiées à ce jour ...

"Social Media Mining : An Introduction" par Reza Zafarani, Mohammad Ali Abbasi, et Huan Liu (2014)

Le "Social Media Mining" est un sous-domaine du "data mining" spécifiquement appliqué aux données sociales et devenu crucial pour les entreprises et les chercheurs qui cherchent à comprendre le comportement humain en ligne et à exploiter les données massives générées par les réseaux sociaux.

Il débute par la collecte de données issues de diverses sources en ligne, telles que les réseaux sociaux (Facebook, Twitter, LinkedIn), les forums, les blogs, et autres plateformes de communication en ligne. L'une des principales tâches du "social mining" est l'analyse des interactions entre les utilisateurs, de la détection des communautés à l'identification des influenceurs, en passant par l'analyse des réseaux sociaux (Social Network Analysis, SNA) ou l'étude des dynamiques de groupes. Les résultats peuvent être utilisés dans de nombreux domaines, marketing ciblé, veille concurrentielle, gestion de la réputation en ligne, personnalisation de contenu, développement de produits, analyse de marché, etc.

Le livre nous introduit en préambule aux concepts de base du "social media mining" et couvre les fondements théoriques, les techniques, et les outils nécessaires pour analyser les données provenant des plateformes de médias sociaux.

Les auteurs nous expliquent comment collecter, prétraiter et transformer les données des médias sociaux pour les rendre exploitables, dont des méthodes pour gérer le bruit, les données manquantes, et la diversité des formats de données.

Les auteurs couvrent ensuite un très large éventail d'algorithmes utilisés pour l'analyse des médias sociaux, tels que le filtrage collaboratif, la détection des communautés, la prédiction des liens, et l'analyse des sentiments, autant d'algorithmes essentiels pour comprendre les interactions entre les utilisateurs, identifier les tendances et prévoir les comportements.

Une partie importante du livre est dédiée à l'analyse des réseaux sociaux (Social Network Analysis - SNA) et nous aide ainsi à comprendre les structures sous-jacentes des réseaux sociaux et l'influence des utilisateurs. Enfin, sont abordées certaines des questions éthiques liées à l'exploitation des données des médias sociaux, telles que la confidentialité des utilisateurs, l'exploitation des données à des fins de manipulation, et l'impact des algorithmes sur les comportements en ligne...

"The Feel of Algorithms" written by Minna Ruckenstein (2023)

Minna Ruckenstein, professeur de technologies émergentes dans la société à l’université d’Helsinki, s'interroge sur la façon dont les individus perçoivent, interagissent avec et sont affectés par les systèmes algorithmiques, comment ceux-ci influencent la vie quotidienne, influent sur nos décisions, nos comportements et même nos émotions. L'ouvrage met ainsi en évidence la présence souvent invisible mais omniprésente des algorithmes dans nos existences, en mettant en évidence notamment leur rôle dans divers contextes sociaux et culturels. Et c'est ainsi que l'auteur nous offre une singulière approche en suggérant que notre relation avec ces systèmes ne sont pas seulement intellectuels mais aussi émotionnels. Cette "sensation" des algorithmes (This "feel" of algorithms) est construite par la façon dont ils sont intégrés et influencent les activités quotidiennes, des interactions sur les médias sociaux aux décisions financières. L’auteur discute également des dynamiques de pouvoir en jeu, où les individus peuvent ressentir une perte de contrôle ou d’agence due à la nature opaque des processus algorithmiques. Le document explore plus avant la façon dont les gens s’adaptent à ces systèmes et y résistent, en élaborant parfois des stratégies pour les naviguer ou les manipuler. Cette interaction peut donner un sentiment d’autonomie, mais elle soulève également des préoccupations éthiques au sujet de la transparence, de l’équité et de la responsabilité dans le processus décisionnel algorithmique.

"... I had been studying how people’s visions, ideas, aims, and behaviors are shaped by emerging technologies for years. I had ample resources to explore the experiential realms of the algorithmic; the collected material alone contained dozens of interviews conducted between 2017 and 2020. What I was lacking, however, was a framework for demonstrating that experiences with algorithms were patterned to such a degree that we could talk about algorithmic culture. Rather than placing experiences with algorithms into a ready-made framework of “algorithmic culture” or “algorithmic life,” I wanted to investigate how algorithmic relations and imaginaries constitute culturally recognizable patterns and thereby shape the everyday. Thus, my aim was not to claim that algorithms have taken over our lives and are mercilessly controlling our minds and whole societies, but rather that the everyday is shaped and touched by algorithms and is coevolving with them. And to understand how this happens, we need to study how algorithms become participants in mundane visions and practices and what kinds of traces they leave in the process.

« ... Cela faisait des années que j'étudiais la manière dont les visions, les idées, les objectifs et les comportements des gens sont façonnés par les technologies émergentes. Je disposais d'amples ressources pour explorer les domaines expérientiels de l'algorithmique ; le matériel recueilli contenait à lui seul des dizaines d'entretiens menés entre 2017 et 2020. Il me manquait cependant un cadre pour démontrer que les expériences avec les algorithmes étaient suffisamment structurées pour que l'on puisse parler de culture algorithmique. Plutôt que de placer les expériences avec les algorithmes dans un cadre tout fait de « culture algorithmique » ou de « vie algorithmique », je voulais étudier comment les relations et les imaginaires algorithmiques constituent des modèles culturellement reconnaissables et façonnent ainsi le quotidien. Ainsi, mon objectif n'était pas de prétendre que les algorithmes ont pris le contrôle de nos vies et contrôlent sans pitié nos esprits et des sociétés entières, mais plutôt que le quotidien est façonné et touché par les algorithmes et qu'il coévolue avec eux. Et pour comprendre comment cela se produit, nous devons étudier comment les algorithmes deviennent des participants dans les visions et les pratiques banales et quels types de traces ils laissent dans le processus.

Thinking about the community college lecture, I decided that I would try to write about algorithmic culture in a manner that would be accessible to a larger public than my usual academic writings. One way to do this would be to review what I had been doing for nearly a decade and plot the evolution of the idea that algorithmic experiences are culturally patterned yet can tell a generalizable story of attempts to live well with algorithmic systems. Once I ventured on this journey, I was pushed in a direction that required that the feelings triggered by algorithms be taken seriously. This is what happens with open-ended empirical research: it forces you to listen to what the gathered material has to say. When I was reading the interview transcripts, the emotional responses to algorithms were by far the most interesting aspect of the material. They suggested that our technology relations have become affectively charged in a new way. We feel excited, afraid, and frustrated in algorithmic relations, often without knowing exactly why.

En pensant à la conférence de l'université communautaire, j'ai décidé d'essayer d'écrire sur la culture algorithmique d'une manière qui serait accessible à un public plus large que mes écrits académiques habituels. Une façon d'y parvenir serait de revoir ce que je faisais depuis près d'une décennie et de retracer l'évolution de l'idée selon laquelle les expériences algorithmiques sont culturellement structurées, tout en pouvant raconter une histoire généralisable des tentatives de bien vivre avec les systèmes algorithmiques. Une fois que je me suis aventuré dans cette voie, j'ai été poussé dans une direction qui exigeait que les sentiments déclenchés par les algorithmes soient pris au sérieux. C'est ce qui se passe avec la recherche empirique ouverte : elle vous oblige à écouter ce que le matériel recueilli a à dire. Lorsque j'ai lu les transcriptions des entretiens, les réactions émotionnelles aux algorithmes étaient de loin l'aspect le plus intéressant du matériel. Elles suggèrent que nos relations avec la technologie sont devenues chargées affectivement d'une nouvelle manière. Nous nous sentons enthousiastes, effrayés et frustrés dans les relations algorithmiques, souvent sans savoir exactement pourquoi.

Algorithm-related feelings were not an entirely new theme for me. I had discussed the emotionally charged nature of algorithm talk when I presented initial research findings in public discussions to various audiences, including fellow researchers, technology and communication professionals, policy makers, and other interested gatherings. These talks triggered animated discussions; people could relate to the feelings I was talking about. They too had felt pleasure, fear, distrust, frustration, and irritation in their everyday algorithmic encounters. Yet I had avoided digging deeper into the emotional aspects present in my empirical material.

Inadvertently, I had internalized a larger trend that treats technical, political, economic, social, and ethical developments as important and worth exploring, while downplaying emotionally charged responses to algorithms.

Despite decades of research on cultural patterning of emotions, it is common to think of emotions as detached from ethical ambivalences and political-economic developments. By using the collected interview material, I could push back on the trend of separating feeling and being from knowing; delve into the emotional-experiential realm; and use personal experiences to highlight the shared understandings of, and reactions to, the everyday manifestations of corporately produced algorithms. This could reveal important similarities between disparate algorithmically mediated practices, such as dating, listening to music, tracing sleep, and reading the news.

Les sentiments liés aux algorithmes n'étaient pas un thème entièrement nouveau pour moi. J'avais déjà abordé la nature émotionnelle du discours sur les algorithmes lorsque j'avais présenté les résultats de mes recherches initiales lors de débats publics devant divers publics, notamment des collègues chercheurs, des professionnels de la technologie et de la communication, des décideurs politiques et d'autres groupes intéressés. Ces exposés ont donné lieu à des discussions animées ; les gens pouvaient s'identifier aux sentiments dont je parlais. Eux aussi avaient ressenti du plaisir, de la peur, de la méfiance, de la frustration et de l'irritation lors de leurs rencontres quotidiennes avec des algorithmes. Pourtant, j'avais évité d'approfondir les aspects émotionnels présents dans mon matériel empirique. Par inadvertance, j'avais intériorisé une tendance plus large qui considère les développements techniques, politiques, économiques, sociaux et éthiques comme importants et dignes d'être explorés, tout en minimisant les réactions émotionnelles aux algorithmes.

Malgré des décennies de recherche sur la structuration culturelle des émotions, il est courant de penser que les émotions sont détachées des ambivalences éthiques et des développements politico-économiques. En utilisant le matériel d'entretien recueilli, je pourrais aller à l'encontre de la tendance à séparer le sentiment et l'être du savoir, plonger dans le domaine émotionnel-expérientiel et utiliser les expériences personnelles pour mettre en évidence les compréhensions partagées et les réactions aux manifestations quotidiennes des algorithmes produits par les entreprises. Cela pourrait révéler d'importantes similitudes entre des pratiques disparates médiatisées par des algorithmes, telles que les rencontres, l'écoute de la musique, la traçabilité du sommeil et la lecture des nouvelles.

Furthermore, I could tie these practices to the broader landscape of informational asymmetries. The Feel of Algorithms explores a cultural shift in contemporary society, one that promotes affectively charged technology relations that most of us will have to acknowledge and account for in one form or another. The study of emotions offers an intervention in discussions that ignore everyday responses to algorithmic systems: how people promote, evaluate, and act in relation to them. Such an intervention, this book argues, is needed to balance the current discussion, which has a tendency to draw conclusions about algorithmic technologies based on celebratory or oppositional responses to imagined future effects. An everyday focus zooms into experiences ofpleasure, fear, and irritation, highlighting how the political aims and ethical tensions play out in people’s visions, practices, and emotional responses...."

En outre, je pourrais relier ces pratiques au paysage plus large des asymétries informationnelles. The Feel of Algorithms explore un changement culturel dans la société contemporaine, un changement qui favorise des relations technologiques chargées d'affectivité que la plupart d'entre nous devront reconnaître et prendre en compte sous une forme ou une autre. L'étude des émotions permet d'intervenir dans les discussions qui ignorent les réponses quotidiennes aux systèmes algorithmiques : comment les gens promeuvent, évaluent et agissent par rapport à eux. Selon cet ouvrage, une telle intervention est nécessaire pour équilibrer le débat actuel, qui a tendance à tirer des conclusions sur les technologies algorithmiques en se basant sur des réponses de célébration ou d'opposition à des effets futurs imaginés. L'accent mis sur le quotidien permet de zoomer sur les expériences de plaisir, de peur et d'irritation, en soulignant comment les objectifs politiques et les tensions éthiques se manifestent dans les visions, les pratiques et les réactions émotionnelles des gens.... »

"Automating Inequality : How High-Tech Tools Profile, Police, and Punish the Poor", Virginia Eubanks (2018)

Bien que le livre se concentre sur l'automatisation dans les services publics, il offre une critique puissante et bien documentée de l'utilisation des technologies automatisées dans ce secteur, américain. Il montre comment ces technologies, loin d'être neutres ou bénéfiques, exacerbent les inégalités existantes et ciblent de manière disproportionnée les communautés pauvres et marginalisées.

Virginia Eubanks nous explique comment les systèmes automatisés utilisés pour gérer les services sociaux, tels que les aides publiques, le logement, et les soins de santé, sont souvent conçus de manière à perpétuer des préjugés contre les pauvres. Ces technologies, censées être efficaces et équitables, finissent par pénaliser les personnes déjà vulnérables, et trois études de cas viennent compléter ici la perspective critique (l'Indiana, - l'automatisation des demandes de prestations sociales a conduit à des erreurs massives et à l'exclusion de milliers de personnes des services auxquels elles avaient droit - ; Los Angeles, - le système de gestion des sans-abri a imposé une automatisation conséquente de la surveillance et la stigmatisation des sans-abri; Pittsburgh, comment un système de prévision du risque d'abus sur enfants a discriminé les familles pauvres et minoritaires en les ciblant de manière disproportionnée...

C'est bien une massive critique du Mythe de la Neutralité Technologique qui est ici particulièrement soulignée. Cette technologie n'est ni intrinsèquement neutre ni même objective. Les algorithmes et les systèmes automatisés sont le plus souvent influencés par les mêmes préjugés que les humains qui les conçoivent, ce qui conduit à des décisions injustes et à la perpétuation des inégalités. Et en relatant des exemples et histoires personnelles, les conséquences dévastatrices des erreurs technologiques et des décisions automatisées sur la vie des gens prennent un relief particulier, humain.

C'est donc une approche plus humaine et plus juste dans la conception et la mise en œuvre des technologies de gestion des services sociaux, que réclame Virginia Eubanks : et c'est avec force qu'elle dénonce cette "gouvernance algorithmique", concept qu'elle introduit, qui tend à s'imposer progressivement, généralisant un contexte dans lequel les décisions politiques et administratives sont de plus en plus prises par des systèmes automatisés ...